Résumé d’ouverture: Le Reinforcement Learning from Human Feedback (RLHF) incarne une approche puissante qui combine apprentissage par renforcement et retours humains pour aligner les systèmes d’IA sur des valeurs et préférences humaines complexes. En 2025, cette méthode est devenue un élément central pour améliorer la robustesse, l’exploration et la capacité des agents à produire des réponses plus naturelles et pertinentes, que ce soit dans le traitement du langage, les agents conversationnels ou les jeux vidéos. En s’appuyant sur des contributions de grands acteurs comme OpenAI, DeepMind, Anthropic AI et Google Research, les chercheurs imaginent des cadres plus sûrs et plus efficaces, tout en s’interrogeant sur les biais et les stratégies optimales de collecte des préférences humaines. Cette synthèse explore les fondements, les cas d’usage, les défis et les perspectives futures, en s’appuyant sur des exemples réels et des ressources de référence dans le domaine.

En bref

- RLHF utilise un modèle de récompense appris à partir des préférences humaines pour guider l’apprentissage par renforcement.

- Les domaines d’application incluent le NLP (conversations, résumés, compréhension) et les agents dans les jeux vidéo, où les agents apprennent à privilégier des comportements humains désirables.

- Les défis clés portent sur l’alignement des préférences, la robustesse face à des préférences stratégiques et la gestion des biais de données humaines.

- Les acteurs majeurs de l’écosystème incluent OpenAI, DeepMind, Meta AI, Microsoft Research, et des outils de Hugging Face.

- Pour approfondir, des ressources d’actualité et des cas d’étude sont disponibles via plusieurs articles et blogs spécialisés.

Harnessing Human Insight: RLHF en 2025 — comprendre les mécanismes, l’architecture et les enjeux

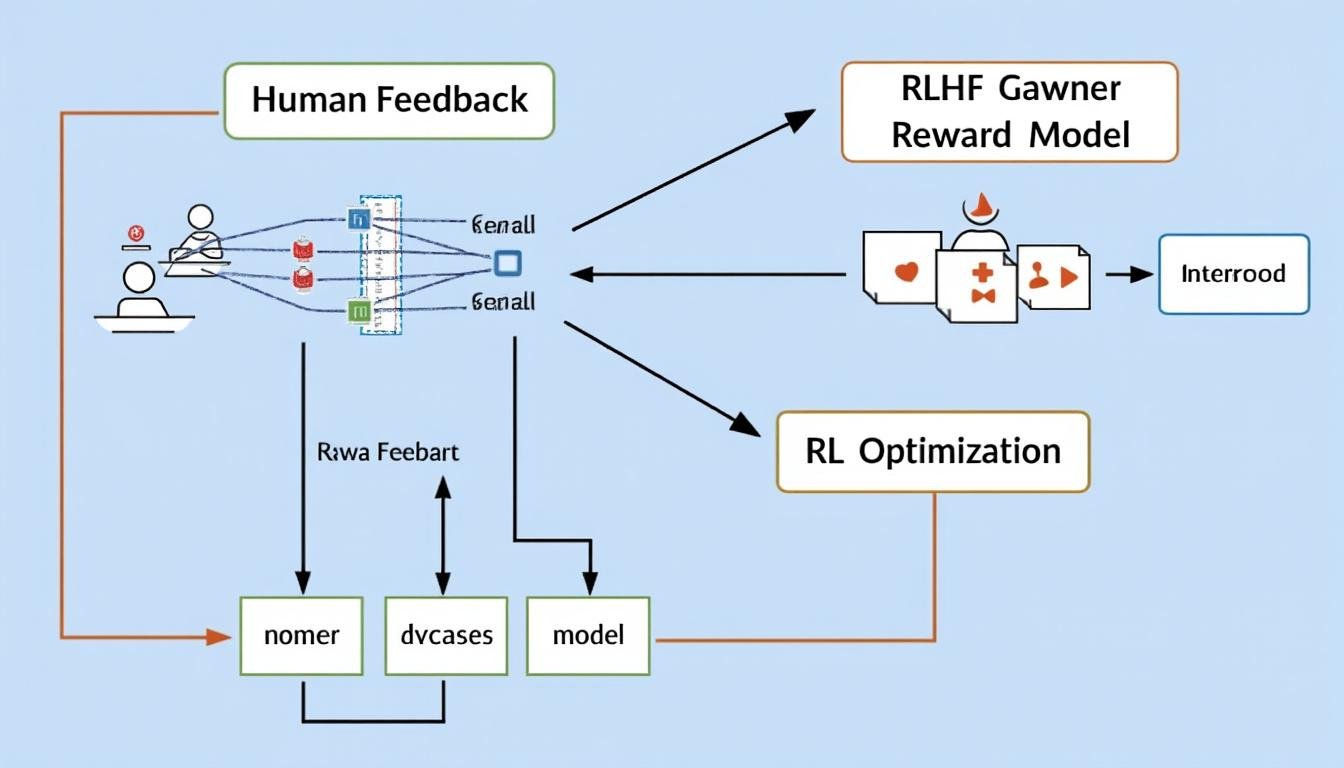

Le RLHF est une technique qui optimise une politique d’agent par l’intermédiaire d’un modèle de récompense formé à partir de retours humains. Dans ce schéma, des humains classent ou notent des comportements de l’agent, et ces préférences alimentent un système de récompense utilisé par des algorithmes de renforcement pour guider l’entraînement. Cette approche permet de contourner les difficultés liées à la définition explicite d’un objectif, en particulier lorsque les récompenses réelles sont jamais totalement alignées avec les valeurs humains ou lorsqu’elles sontsparses ou bruitées.

Les composantes essentielles du cadre RLHF en 2025 incluent :

- La collecte de préférences humaines et leur transformation en signaux de récompense utilisables.

- La construction d’un modèle de récompense qui peut être affiné à travers des itérations et des scénarios variés.

- Une phase d’optimisation par apprentissage par renforcement utilisant ce signal, afin de produire des politiques plus conformes aux objectifs humains.

- Des mécanismes de contrôle et d’audit pour limiter les biais et éviter les manipulations stratégiques des préférences.

| Aspect | Description | Exemple |

|---|---|---|

| Donnees de préférence | Classements ou évaluations fournies par des humans pour guider l’agent | Rangs de dialogues générés par un assistant IA |

| Modèle de récompense | Fonction qui convertit les préférences en récompense numérique | Récompense positive pour des réponses conformes à des valeurs humaines |

| Algorithme d’optimisation | RL utilisé pour maximiser les récompenses apprises | Policy gradient ou autres méthodes modernes |

| Équilibrage sécurité | Contrôles pour prévenir les biais et l’exploitation des préférences | Validation croisée et audits de biais |

Pour enrichir le contexte actuel, plusieurs ressources techniques et articles de référence convergent vers des résultats prometteurs en NLP et dans les agents jeux. Des publications récentes illustrent comment OpenAI et ses pairs expérimentent l’alignement des modèles avec des préférences humaines plus nuancées, tout en restant attentifs à la sécurité et à la robustesse. Des ressources complémentaires et analyses comparatives sont disponibles dans les guides et blogs listés ci-dessous, avec des exemples concrets intégrant les résultats de Google Research, Microsoft Research et Hugging Face.

Ressources et lectures recommandées (liens utiles à consulter)

- Insights and Innovations in AI – Your Guide to the Latest Blog Articles

- Exploring the Innovations and Impact of Google in the Digital Age

- Insights and Innovations in the World of AI – Blog Articles

- The Remarkable Ability of Neural Networks to Master Diverse Learning Tasks

- Exploring the World of Neural Networks – The Key to Artificial Intelligence

Cas concrets et résultats marquants en NLP et jeux vidéo

Dans le domaine du traitement du langage naturel, RLHF permet d’obtenir des systèmes qui répondent de manière plus alignée avec les attentes humaines, en générant des réponses plus riches et nuancées. Les applications touchent la conversation, la synthèse, et la compréhension fine du langage, là où les signaux de récompense classiques peinent à être définis avec précision. Par ailleurs, des bots de jeux vidéo propulsés par RLHF ont dépassé des performances humaines dans des environnements complexes, démontrant la capacité des agents à apprendre des préférences humaines dans des tâches dynamiques et variées.

- Exemples NLP: conversations plus naturelles, résumés mieux ciblés et compréhension contextuelle plus robuste.

- Exemples jeux: bots capables d’adaptation rapide et stratégies alignées sur des objectifs humains.

- Défis typiques: gestion des biais de préférence, robustesse face aux préférences stratégiques et coût d’étiquetage des données humaines.

| Cas d’usage | Avantages | Limites et risques |

|---|---|---|

| NLP conversationnel | Réponses plus pertinentes et détaillées | Coût élevé des données humaines, biais potentiels |

| Jeux et simulations | Apprentissage rapide de stratégies humaines | Risque d’exploitation des préférences mal alignées |

Les avancées récentes s’appuient sur les travaux d’acteurs clés tels que Anthropic et Stability AI, tout en restant connectées avec les efforts de Allen Institute for AI et le large écosystème Hugging Face. Pour suivre les évolutions et les retours d’expérience, consultez les sources ci-dessous et les études de cas qui mettent en lumière les progrès en 2025, y compris les contributions de Microsoft Research et Google Research.

Défis, sécurité et trajectoires pour 2025 et au-delà

À mesure que RLHF gagne en adoption, les questions d’alignement, de sécurité et de robustesse prennent une importance croissante. Les défis incluent la détection et la prévention des biais dans les retours humains, la résistance aux attaques d’alignement, et la gestion de la variabilité des préférences entre utilisateurs. Les approches modernes intègrent des mécanismes d’audit, des tests de robustesse et des cadres multi-agent pour calibrer les récompenses dans des environnements dynamiques. Les progrès s’inscrivent dans une communauté qui regroupe des acteurs comme OpenAI, DeepMind, Google Research, Meta AI, et des plates-formes telles que Hugging Face.

- Éthique et biais: méthodes de détection et mitigation des biais dans les préférences humaines.

- Robustesse: évaluation de l’agent dans des scénarios adverses et bruités.

- Économie du coût: optimiser le procédé de collecte de préférences pour des usages à grande échelle.

| Défi | Approche | Illustration |

|---|---|---|

| Biais et manipulation | Audits externes et cadres d’évaluation diversifiés | Tests croisés sur plusieurs groupes de préférences |

| Coût des données humaines | Utilisation efficace des classements et apprentissage par échantillonnage | Itérations plus rapides avec réduction des étiquettes |

Pour approfondir ces questions et découvrir des cas réels, consultez les ressources qui illustrent les dynamiques de RLHF et ses applications actuelles, en particulier celles liées à OpenAI, Anthropic AI, et les initiatives de Microsoft Research et Google Research. Les liens ci-dessous offrent un panorama utile, y compris des analyses sur les types d’IA et les méthodes d’apprentissage associées.

- Reinforcement Learning and Decision Making

- Exploring the Depths of Reinforcement Learning

- Innovations of DeepMind – Pioneering AI Research

- OpenAI’s Impact on Artificial Intelligence

- Exploring the Different Types of Artificial Intelligence

Pour en savoir plus, reportez-vous aussi aux ressources officielles et blogs des acteurs majeurs cités, qui fournissent des démonstrations et des comparatifs entre les approches RLHF et d’autres formulations d’alignement.

Remarque finale: L’écosystème RLHF évolue rapidement, avec des avancées qui redéfinissent l’alignement, la sécurité et l’efficacité des systèmes IA en 2025 et au-delà. Pour rester informé, suivez les publications et les démonstrations des acteurs majeurs du secteur et explorez les ressources recommandées ci-dessus.