- En 2025, le Machine Learning transforme les décisions métier grâce à des insights data plus rapides et plus pertinents.

- Maîtriser les frameworks clés comme TensorFlow, PyTorch et Scikit-learn est indispensable pour passer de la théorie à l’implémentation réelle.

- Les plateformes cloud et les solutions MLOps (Azure Machine Learning, Amazon SageMaker, Google Cloud AI, etc.) accélèrent l’innovation tout en renforçant la gouvernance et la sécurité.

- Les enjeux éthiques et la fiabilité des modèles restent centraux pour garantir des décisions équitables et transparentes.

- Les cas d’usage couvrent l’entreprise, la santé, la finance et la recherche, démontrant que les données restent le levier principal de compétitivité.

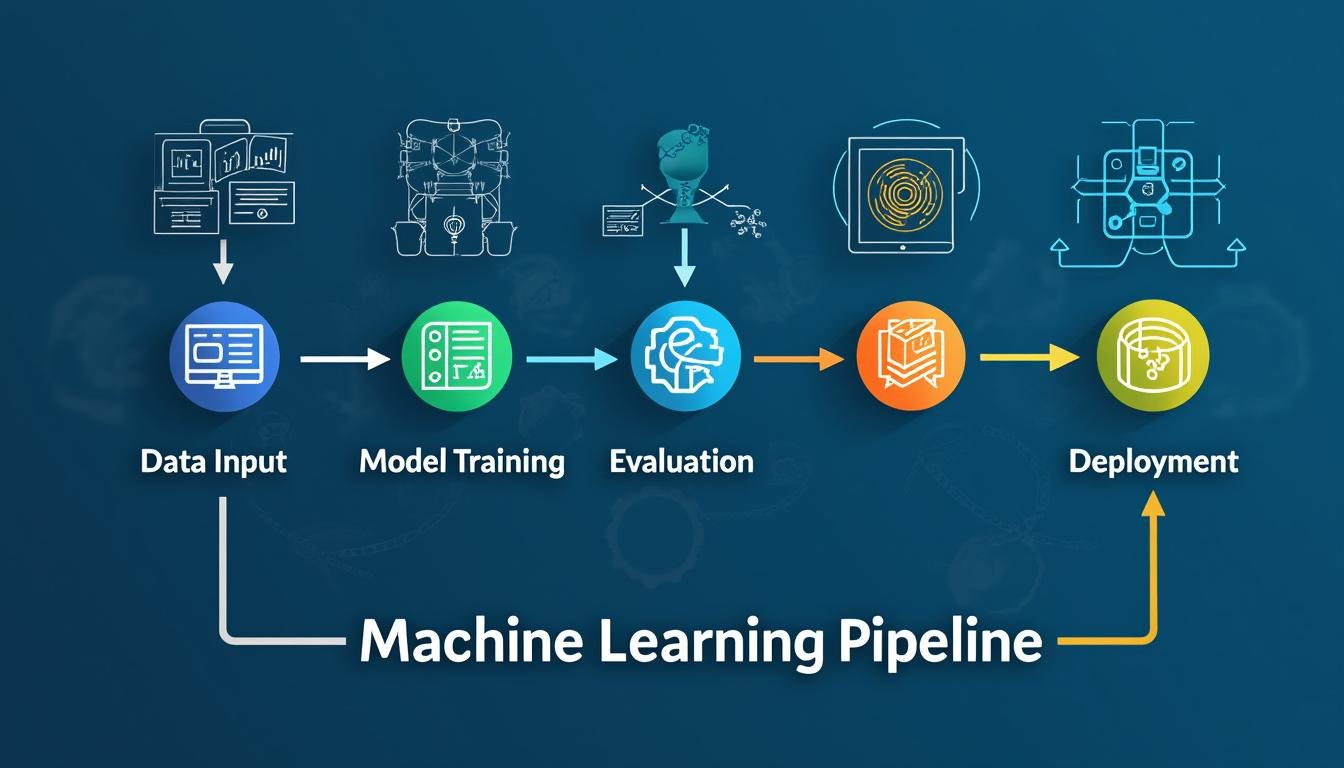

Le Machine Learning est aujourd’hui bien plus qu’un corpus d’algorithmes : c’est une discipline intégrée qui transforme les données en insights opérationnels. En 2025, les organisations doivent naviguer entre rapidité d’expérimentation et rigueur de production. Cette évolution repose sur une compréhension claire des paradigmes d’apprentissage (supervisé, non supervisé, par reinforcement), une maîtrise des outils modernes et une attention soutenue à l’éthique, à la traçabilité et à la robustesse des systèmes. Les architectures évoluent vers des pipelines reproductibles et surveillés, où chaque étape — de la préparation des données à l’évaluation finale — est traçable et auditable. Dans ce contexte, les plateformes comme Azure Machine Learning, Amazon SageMaker et Google Cloud AI jouent un rôle clé en fournissant des environnements intégrés pour l’entraînement, le déploiement et le monitoring. L’objectif est clair : transformer les données en décisions éclairées et fiables, tout en restant agiles face à des environnements réglementaires et technologiques en constante évolution.

Maîtriser le Machine Learning: fondements et outils essentiels pour 2025

Pour réussir, il faut d’abord bâtir une base solide: compréhension des données, choix des algorithmes, évaluation rigoureuse et mise en production responsable. Les TensorFlow, PyTorch et Scikit-learn restent les piliers du développement ML, chacun apportant des atouts adaptés à différents scénarios. En parallèle, les outils d’ingénierie des données et les pratiques MLOps permettent de pérenniser les projets, tout en assurant la traçabilité et la reproductibilité indispensable en entreprise. En 2025, savoir naviguer entre ces briques est un vrai différenciateur, que ce soit pour des prédictions métiers ou pour des analyses exploratoires plus profondes. Pour aller plus loin, on peut consulter des ressources variées sur les domaines machine learning, supervised learning et unsupervised learning.

- Principaux paradigmes d’apprentissage:

- Apprentissage supervisé: régression et classification.

- Apprentissage non supervisé: regroupement, réduction de dimensionnalité.

- Apprentissage par reinforcement: agents et environnements pour des décisions séquentielles.

- Apprentissage supervisé: régression et classification.

- Apprentissage non supervisé: regroupement, réduction de dimensionnalité.

- Apprentissage par reinforcement: agents et environnements pour des décisions séquentielles.

- Cadres et outils incontournables:

- TensorFlow et PyTorch pour le développement de modèles avancés.

- Scikit-learn pour des solutions rapides et robustes en prototypage.

- Solutions complètes: H2O.ai, DataRobot.

- Plateformes cloud: Azure Machine Learning, Amazon SageMaker, Google Cloud AI.

- Outils d’intégration et d’ETL: RapidMiner, BigML.

- TensorFlow et PyTorch pour le développement de modèles avancés.

- Scikit-learn pour des solutions rapides et robustes en prototypage.

- Solutions complètes: H2O.ai, DataRobot.

- Plateformes cloud: Azure Machine Learning, Amazon SageMaker, Google Cloud AI.

- Outils d’intégration et d’ETL: RapidMiner, BigML.

- Référence pratique:

- Évaluez vos modèles avec des métriques adaptées (Accuracy, F1, AUC, RMSE, lift, calibration).

- Favorisez la reproductibilité: versionnage des jeux de données et des scripts, tests unitaires et journaux d’entraînement.

- Évaluez vos modèles avec des métriques adaptées (Accuracy, F1, AUC, RMSE, lift, calibration).

- Favorisez la reproductibilité: versionnage des jeux de données et des scripts, tests unitaires et journaux d’entraînement.

| Aspect | Description | Outils/Frameworks |

|---|---|---|

| Préparation des données | Nettoyage, normalisation, ingénierie des caractéristiques, gestion des valeurs manquantes. | pandas, NumPy, Scikit-learn préprocessing |

| Modèles et algorithmes | Choix entre régression, classification, clustering, réseaux de neurones et méthodes d’ensemble. | TensorFlow, PyTorch, Scikit-learn |

| Évaluation | Split train/valid, métriques adaptées, robustesse et biais. | Scikit-learn metrics, Yellowbricks, A/B tests |

| Déploiement | CI/CD ML, monitoring, drift et alertes en production. | Azure ML, SageMaker, Google Cloud AI, MLflow |

| Gouvernance | Éthique, traçabilité, explication des décisions et conformité. | Explainable AI, audit logs, Data governance tools |

Pour approfondir les options et les cadres, voici quelques ressources utiles: TensorFlow et frameworks ML/DL, reinforcement learning, et éthique et intelligence artificielle. Pour une approche pratique, consultez aussi les répertoires dédiés à l’introduction et aux méthodes supervisées et non supervisées.

Les concepts clés prennent forme lorsque la théorie rejoint l’expérimentation. Le prochain extrait vidéo illustre les étapes de prototypage et les pièges courants lors du passage à la production.

Approfondir les pratiques ML et MLOps

En complément du développement, l’intégration d’outils MLOps facilite le passage à l’échelle et la maintenance des modèles. L’équilibre entre rapidité et fiabilité est au cœur des choix d’architecture. Pour enrichir votre pratique, découvrez des ressources axées sur l’apprentissage supervisé et l’intégration continue des modèles dans les flux opérationnels.

Du prototypage à la production: déployer des modèles ML fiables

Le passage du prototypage à la production nécessite une discipline plus structurée: pipelines reproductibles, gestion des versions, tests rigoureux et supervision continue. Les plateformes comme Azure Machine Learning, Amazon SageMaker et Google Cloud AI offrent des environnements cohérents pour l’entraînement, le déploiement et le monitoring des modèles. En pratique, cela se traduit par une séparation claire entre les domaines data, modèle et ops, avec des mécanismes de rollback et de détection de dérive. L’objectif est de préserver la qualité des prédictions tout en réduisant les coûts et les risques opérationnels. Pour enrichir cette approche, explorez des ressources sur l’orchestration des flux, les pipelines CI/CD ML et les tests de modèles, notamment via des cas d’usage et des retours d’expérience mis à jour en 2025.

- Bonnes pratiques de MLOps:

- Versionner les jeux de données et les modèles.

- Automatiser l’entraînement, la validation et le déploiement.

- Mettre en place une surveillance proactive et des alertes en production.

- Versionner les jeux de données et les modèles.

- Automatiser l’entraînement, la validation et le déploiement.

- Mettre en place une surveillance proactive et des alertes en production.

- Technologies et cadres recommandés:

- TensorFlow, PyTorch, Scikit-learn pour le développement.

- Plateformes cloud et outils d’orchestration: Azure ML, SageMaker, Google Cloud AI, RapidMiner, BigML.

- TensorFlow, PyTorch, Scikit-learn pour le développement.

- Plateformes cloud et outils d’orchestration: Azure ML, SageMaker, Google Cloud AI, RapidMiner, BigML.

- Cas d’usage et scénarios:

- Prévision de demande, détection d’anomalies, recommandation, etc.

- Implémentation progressive avec pilotage par faible risque et montée en complexité.

- Prévision de demande, détection d’anomalies, recommandation, etc.

- Implémentation progressive avec pilotage par faible risque et montée en complexité.

Pour approfondir les aspects techniques et opérationnels, consultez les guides disponibles en ligne et les ressources dédiées à l’intégration continue et au monitoring des modèles, notamment à travers des ressources comme reinforcement learning et supervised learning guide.

Entre les sections, il est utile de rappeler que le déploiement efficace repose sur des pratiques robustes de monitoring et de gestion des dérives.

Préparer une production ML fiable: processus et contrôles

Les éléments clés pour un déploiement fiable incluent la traçabilité des données, la reproductibilité des entraînements et des évaluations, ainsi que des mécanismes de test adaptés. Une architecture de production doit aussi intégrer des contrôles de sécurité et des garanties de conformité. Consultez les ressources de référence sur le sujet et familiarisez-vous avec les cadres H2O.ai et DataRobot pour accélérer les déploiements tout en maintenant des standards élevés de qualité et d’éthique. Découvrez aussi les perspectives de unsupervised learning patterns et d’autres guides pratiques.

| Aspect | Description | Exemples/Bonnes pratiques |

|---|---|---|

| CI/CD ML | Automatisation du cycle d’entraînement à la mise en production et des tests de régression. | Git, MLflow, pipelines Jenkins/Azure DevOps |

| Monitoring & drift | Surveillance des performances et détection des dérives des données et des modèles. | Prometheus, Grafana, Amazon CloudWatch |

| Sécurité & conformité | Contrôles d’accès, audits, insistence sur l’éthique et la confidentialité. | IAM, chiffrement, logs d’audit |

| Gouvernance des données | Traçabilité et gestion des versions des jeux de données. | Data catalogs, lineage tools |

Pour approfondir, consultez ce guide sur TensorFlow et cadres ML et d’autres ressources sur semi-supervised learning.

Transition vers le prochain volet: la responsabilité, l’éthique et la gouvernance deviennent des composantes essentielles de tout écosystème ML, afin de garantir des décisions sincèrement fiables et expliquables pour les utilisateurs et les parties prenantes.

La présentation vidéo précédente montre comment éviter les écueils fréquents lors de la mise en production et illustre des exemples concrets rencontrés en 2024-2025.

Éthique, gouvernance et fiabilité dans le ML

La dimension éthique et la gouvernance des modèles ML ne sont pas des ajouts décoratifs: elles conditionnent la confiance et l’adoption des technologies. En 2025, les organisations doivent intégrer des mécanismes d’audit, d’explicabilité et de conformité dès les premières étapes du développement. Cela signifie penser fairness, robustesse et transparence, et prévoir des plans d’intervention en cas d’erreur ou de biais détecté. Les cadres de régulation et les standards émergents guident ces pratiques, mais l’initiative revient aussi à chaque équipe ML: concevoir des systèmes qui expliquent leurs décisions, qui peuvent être vérifiés et qui respectent les droits des utilisateurs. Pour enrichir la réflexion, consultez des ressources sur l’audit des modèles et les meilleures pratiques en expliqueability et en éthique algorithmique, ainsi que les cas d’études présentés par les plateformes et les communautés ML.

- Principes clés d’éthique ML:

- Équité, transparence et explicabilité.

- Prévention des biais et gestion des risques.

- Respect de la confidentialité et de la sécurité des données.

- Équité, transparence et explicabilité.

- Prévention des biais et gestion des risques.

- Respect de la confidentialité et de la sécurité des données.

- Gouvernance et conformité:

- Traçabilité des jeux de données et des décisions modélisées.

- Audits réguliers et documentation complète.

- Contrôles d’accès et contrôle des dérives en production.

- Traçabilité des jeux de données et des décisions modélisées.

- Audits réguliers et documentation complète.

- Contrôles d’accès et contrôle des dérives en production.

- Bonnes pratiques pour 2025:

- Inclure des tests d’explicabilité dans les pipelines ML.

- Mettre en place des simulateurs pour évaluer les risques dans des scénarios extremes.

- Impliquer les parties prenantes métier et éthiques tout au long du développement.

- Inclure des tests d’explicabilité dans les pipelines ML.

- Mettre en place des simulateurs pour évaluer les risques dans des scénarios extremes.

- Impliquer les parties prenantes métier et éthiques tout au long du développement.

| Thème | Préoccupations | Actions recommandées |

|---|---|---|

| Explicabilité | Comprendre pourquoi un modèle prend telle décision. | Utiliser LIME/SHAP, rapports d’explicabilité, visualisations. |

| Audits & traçabilité | Documenter le cycle de vie du modèle et des données. | Ledger des entraînements, journaux d’audit, versionnage des données. |

| Biais et sécurité | Identifier et corriger les biais, protéger les données sensibles. | Tests de biais, dé-identification, politiques d’accès. |

| Conformité | Respect des cadres juridiques et éthiques locaux. | Cartographie des exigences, contrôles de conformité, revue éthique. |

Pour poursuivre votre réflexion, découvrez des ressources et des exemples autour des sujets tests d’intelligence et éthique, reinforcement learning et éthique, et risques et scénarios.

Cas d’usage et stratégies d’apprentissage: de l’entreprise à la recherche

Les applications du ML couvrent un large spectre, des prédictions opérationnelles aux découvertes scientifiques. En 2025, les entreprises adoptent des cadres analytiques plus sophistiqués et hybrides, combinant apprentissage supervisé et non supervisé pour révéler des insights plus profonds. Les cas d’usage se déploient dans la chaîne d’approvisionnement, la santé, la finance et la recherche, mais ils exigent une planification soignée: définition d’indicateurs clairs, gestion du risque et mécanismes de contrôle qualité. Les outils comme RapidMiner et BigML complètent les options existantes et facilitent le prototypage rapide, tandis que les plateformes cloud soutiennent l’extension des modèles à l’échelle. Pour enrichir votre vision, parcourez des articles et guides sur les paradigmes d’apprentissage et les scénarios concrets, et explorez les ressources listées ci-dessous.

- Exemple d’application en entreprise:

- Prédiction de la demande et optimisation des stocks.

- Détection d’anomalies et assurance qualité.

- Personnalisation et recommandation client.

- Prédiction de la demande et optimisation des stocks.

- Détection d’anomalies et assurance qualité.

- Personnalisation et recommandation client.

- Etendue des environnements:

- Sur site, cloud ou hybridation pour répondre à des exigences de sécurité et de latence.

- Intégration avec Azure Machine Learning, Amazon SageMaker, Google Cloud AI.

- Sur site, cloud ou hybridation pour répondre à des exigences de sécurité et de latence.

- Intégration avec Azure Machine Learning, Amazon SageMaker, Google Cloud AI.

| Cas d’usage | Bénéfices | Exemples/Études de cas |

|---|---|---|

| Prévision de la demande | Réduction des stocks, planification précise. | Industrie, retail et logistique |

| Détection d’anomalies | Réduction des défauts et du coût de maintenance. | Fabrication et services |

| Personnalisation | Expérience client améliorée, augmentation du taux de conversion. | e-commerce et fintech |

| Recherche et sciences | Découvertes et validations plus rapides. | Biotech, énergie, environnement |

Pour aller plus loin dans les scénarios d’application et les comparatifs de frameworks, consultez ces ressources complémentaires: reinforcement learning avancé, guide supervisé, et patterns en unsupervised.

Pour compléter, vous pouvez aussi explorer des comparatifs et tutoriels sur TensorFlow et écosystème DL et sur risques émergents.

Qu’est-ce que le machine learning et pourquoi est-il central en 2025 ?

Le machine learning est une approche qui permet aux systèmes d’apprendre à partir des données et d’améliorer leurs performances sans être explicitement programmés. En 2025, il est central car il transforme les données en insights actionnables et soutient les décisions clefs dans les entreprises et la recherche.

Quels frameworks privilégier en 2025 pour démarrer rapidement ?

Pour démarrer rapidement et efficacement, on peut combiner Scikit-learn pour le prototypage, avec TensorFlow et PyTorch pour des modèles plus complexes. Les plateformes cloud comme Azure Machine Learning, Amazon SageMaker et Google Cloud AI facilitent le déploiement et le monitoring en production.

Comment évaluer et surveiller un modèle ML en production ?

On utilise des métriques adaptées (par exemple AUC, F1, RMSE selon le problème), des tests de régression et un système de monitoring pour détecter les dérives de données. L’absence de surveillance peut mener à des prédictions qui se dégradent avec le temps.

Comment intégrer l’éthique et la gouvernance dans un projet ML ?

Intégrer l’explicabilité, réaliser des audits réguliers et documenter le cycle de vie du modèle dès le départ. Impliquer les parties prenantes et respecter les cadres de conformité assure une adoption plus fiable et responsable.